Dans le but de pouvoir stopper proprement un hyperviseur VMware et ses machines virtuelles en cas d’alerte onduleur, voici une solution pour intégrer un client NUT (Network UPS Tools) natif à vSphere Hypervisor (ESXi 5.0, 5.1, 5.5, 6.0, 6.5, 6.7, 7.0, 8.0, 9.0 testés). Le client NUT est installé dans l’hyperviseur et peut être contrôlé et paramétré depuis l’interface de configuration de ESXi ou depuis le vCenter s’il est géré.

Réflexion du 27/04/2025 : Broadcom a racheté VMware et a fait un grand ménage dans les formules commerciales. Pendant un temps ESXi 8 n’étais plus disponible gratuitement avant que Broadcom ne fasse machine arrière. Aussi longtemps que je serai en mesure d’exécuter ESXi dans mon lab je continuerai de mettre à jour le client NUT pour ESXi. A priori ESXi 9 n’est pas encore disponible gratuitement, il fait partie de l’offre commerciale vSphere Foundation.

Mise à jour du 24/07/2025 : ESXi 9.0 est officiellement pris en charge à partir de la version 2.7.1 du module même si les versions précédentes peuvent être installées. C’est aussi à partir de cette version que la compilation pour ESXi for ARM est possible. Le binaire pour architecture ARM est disponible sur le github du projet.

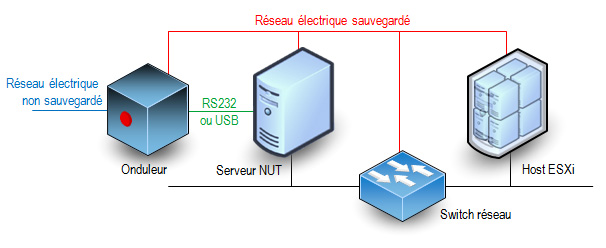

Principe

La procédure consiste à installer dans l’hyperviseur les binaires et scripts nécessaires à la réception des alertes onduleur. Le schéma classique minimal des connexions entre les éléments d’un réseau électrique protégé par un onduleur est le suivant :

Cette solution n’est pas officiellement supportée par VMware et elle ne s’applique qu’à des hyperviseurs standalone. Elle ne peut pas convenir pour des fermes d’hyperviseurs en cluster de haute disponibilité sous le contrôle d’un vCenter. Seul le client NUT est ajouté à l’hyperviseur, l’onduleur doit être surveillé par un serveur NUT indépendant.

Caractéristiques et fonctionnalités

- La méthode d’installation utilise un fichier VIB (vSphere Installation Bundle). Il n’y a rien d’autre ce qui permet une installation rapide et sûre et une désinstallation propre en utilisant les standards de VMware.

- La compatibilité du module a été assurée pour qu’il fonctionne sur toutes les versions de ESXi entre 5.0 et 9.0. Cependant pour les versions 5.x l’installation automatique par déploiement de ViB n’est pas possible, il faut l’installer manuellement en suivant les instructions ci-dessous et passer outre les avertissements de sécurité. A partir de la version 6.0 de ESXi il n’y a plus ce soucis.

- C’est un client NUT 2.8.3 qui est inclus dans le paquetage. Il peut se connecter aux serveurs avec une version plus ancienne (disons 2.6.4 mais je n’ai pas testé les serveurs plus anciens).

- Actuellement seule la version pour processeur x86 est disponible. Il n’y a pas de version pour ESXi ARM (je n’ai ni le besoin ni la plateforme de test/développement pour ça).

- Le client (secondary dans la terminologie NUT) peut se connecter au serveur (primary) en privilégiant une connexion SSL/TLS si elle est disponible. Il ne sera pas fait de vérification de validité de certificat serveur et il n’y a pas de certificat client configurable.

- Le client peut envoyer un mail très succinct à une adresse configurable lors de la réception d’un évènement onduleur (perte du secteur, batterie faible, engagement de l’arrêt, retour du secteur). L’outil mail est très simple et il récupère les informations pour l’envoi des messages du DNS (enregistrements MX). Vous pouvez aussi utiliser un relais SMTP personnel.

- Le client peut se connecter à plusieurs serveurs NUT s’il y a plusieurs onduleurs (cas des serveurs avec une redondance d’alimentation). Il utilisera le même compte et le même mot de passe pour se connecter aux différents serveurs NUT. A vous de déclarer ce compte sur tous les serveurs NUT.

- Normalement il est possible de préciser le port TCP de connexion au serveur NUT sous la forme onduleur@serveur:port mais ESXi impose des règles de firewall pour le trafic sortant et seul le port 3493 est autorisé. C’est le port par défaut des serveurs NUT.

- Il est possible de demander l’arrêt du système ESXi après un laps de temps sur batterie configurable. Le client reste à l’écoute de l’évènement batterie faible et le système entamera sa procédure d’arrêt soit après le temps imparti soit sur évènement de batterie faible, au premier des deux qui surviendra quand le système est sur batterie. L’attente est interrompue si le courant secteur est rétabli entre temps, mais si la procédure d’arrêt a déjà été initiée, elle ira jusqu’à l’extinction du host ESXi.

- Le redémarrage du serveur après une coupure de courant est aussi une phase importante mais c’est à vous de le prévoir avec d’autres outils. Personnellement (mais ce n’est qu’une suggestion) j’aime bien l’idée d’un chef d’orchestre qui redémarre automatiquement. Il surveille le retour des services tels que le réseau, le serveur NUT etc… et il envoie des trames WOL pour réveiller les machines dans l’ordre désiré. Configurez votre serveur NUT pour qu’il ordonne à l’onduleur de couper effectivement le courant pendant un petit laps de temps même si le courant est revenu pendant la procédure d’arrêt. La plupart des onduleurs ont cette fonction avec les libellés « Interval to wait after shutdown with delay command » et « Interval to wait before (re)starting the load ». Certains onduleurs ont aussi une valeur « Minimum battery level for restart after power off » qui est interessante pour attendre que l’onduleur ait suffisamment rechargé ses batteries avant de faire redémarrer le système. Le risque est de se retourner dans une situation où un second arrêt propre serait impossible si une nouvelle coupure de secteur se produit juste après le redémarrage (ce qui est plutôt fréquent).

- Le client tourne avec le compte root. C’est habituellement déconseillé par la documentation du projet NUT mais l’hyperviseur a un nombre très limité de comptes locaux. Ce nombre de compte s’est beaucoup réduit au fil des versions. Des comptes restants, root est le seul encore utilisable.

Téléchargement du module

Pour toutes les versions de ESXi, l’installation peut se faire en ligne de commande sur l’hyperviseur : un fichier TAR compressé doit être déposé sur l’hyperviseur.

Téléchargez ici le fichier

Télécharger “NutClient-ESXi (binaires)” NutClient-ESXi-2.8.3-2.7.1.x86_64.tar.gz – 845,61 Ko

A partir de ESXi 6.0 vous pouvez utiliser le bundle offline pour une installation en ligne de commande en appelant la commande « esxcli software vib install -d » . Ou par le manager de mises à jour du vCenter si vous en avez un.

Téléchargez ici le bundle offline.

Télécharger “NutClient-ESXi (offline bundle)” NutClient-ESXi-2.8.3-2.7.1-x86_64-offline_bundle.zip – 847,29 Ko

Vous pouvez créer votre propre package personnalisé à partir des sources. Elles sont distribuées sous licence GPLv3 (GNU Public License version 3). Utilisez un environnement de développement linux 64 bits tel que CentOS 7 avec les outils de compilation et développement C habituels. Un fichier INSTALL décrit la procédure. Les sources et les binaires pour ESXi for ARM sont disponibles également dans un dépot git publique : NutClient-ESXi

Téléchargez ici les sources

Télécharger “NutClient-ESXi (sources)” NutClient-ESXi-2.8.3-2.7.1-src.tar.gz – 122,05 Ko

Installation

Activez l’accès ssh à votre host ESXi si ce n’est pas déjà fait. Cela est fait à partir de l’interface d’administration ESXi ou de la console DCUI. A partir de l’interface d’administration : dans la rubrique gérer de votre hôte, onglet services, dans la liste sélectionnez TSM-SSH et démarrez le service. Le service ssh sera actif jusqu’au prochain reboot de l’hyperviseur ou pendant un temps limité selon la version de votre ESXi.

Copiez le fichier NutClient-ESXi-2.8.3-2.7.1.x86_64.tar.gz dans le répertoire /tmp du host ESXi. Ici je vous donne l’exemple depuis une machine linux (remplacez 10.0.0.8 par l’adresse IP du host ESXi ou son nom FQDN). Depuis Windows vous pouvez utiliser l’outil gratuit WinSCP.

[root@linux ~]# scp NutClient-ESXi-2.8.3-2.7.1.x86_64.tar.gz root@10.0.0.8:/tmp The authenticity of host '10.0.0.8 (10.0.0.8)' can't be established. RSA key fingerprint is 89:49:ce:6d:... ...:40:76:7a:4a:fe. Are you sure you want to continue connecting (yes/no)? yes Warning: Permanently added '10.0.0.8' (RSA) to the list of known hosts. Password: (saisir le mot de passe administrateur ESXi) NutClient-ESXi-2.8.3-2.7.1.x86_64.tar.gz 100% 869KB 1.9MB/s 00:00

Passez votre hyperviseur au niveau d’acceptance Communauté si ce n’est pas déjà fait !

Connectez-vous root en ssh à l’hôte ESXi et tapez la suite de commandes suivantes pour installer le VIB (l’opération peu être longue si votre système est installé sur une clé USB lente) :

~ # cd /tmp /tmp # tar -xzf NutClient-ESXi-2.8.3-2.7.1.x86_64.tar.gz /tmp # sh upsmon-install.sh Installation Result Message: Operation finished successfully. Reboot Required: false VIBs Installed: Margar_bootbank_upsmon_2.8.3-2.7.1 VIBs Removed: VIBs Skipped:

Vous n’avez pas besoin de rebooter pour commencer à utiliser le client NUT sur votre système. Vous devez toutefois le configurer avant son premier lancement.

Vous pouvez supprimer les fichiers qui ont été créés dans /tmp et désactiver le service SSH

Configuration

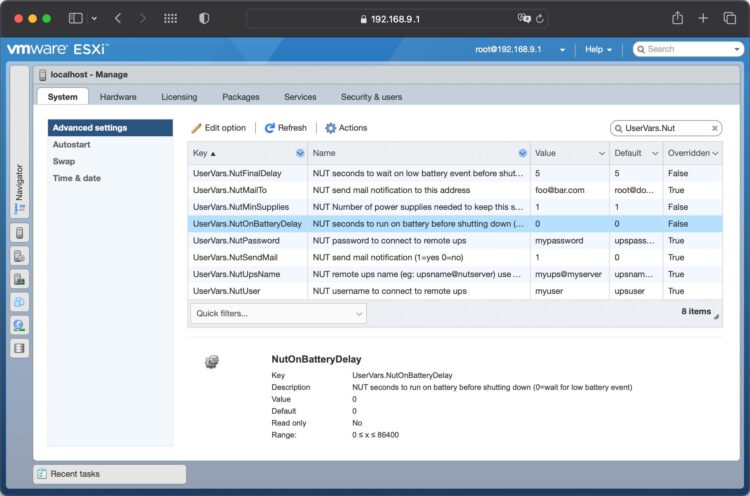

A l’aide de l’interface d’administration du ESXi, rendez-vous dans la rubrique gérer de l’hôte. Sélectionnez les paramètres avancés de l’onglet Système et filtrez la liste sur UserVars.Nut, vous avez 8 variables à configurer :

- UserVars.NutUpsName : Nom de l’onduleur sur le serveur NUT (sous la forme nom_onduleur@nom_ou_ip_serveur). Plusieurs onduleurs peuvent être saisis séparés par un espace. Il n’y aura pas d’arrêt système tant que le dernier onduleur encore debout n’aura pas donné l’ordre d’arrêt.

- UserVars.NutUser : Nom du compte de connexion au serveur NUT

- UserVars.NutPassword : Mot de passe du compte de connexion au serveur NUT

- UserVars.NutFinalDelay : Secondes qu’il faudra attendre après la réception de l’événement batterie faible pour procéder à l’arrêt du système

- UserVars.NutOnBatteryDelay : Délai en secondes après le début du passage sur batterie de l’onduleur pour stopper le système. Si la valeur est 0 alors le client NUT attendra l’évènement batterie faible pour stopper le système. La valeur par défaut est 0, c’est le fonctionnement normal pour garder le système en fonctionnement le plus longtemps possible. Si l’onduleur repasse sur secteur avant la fin du délai, le système ne sera pas stoppé.

- UserVars.NutSendMail : A mettre à 1 pour que le client NUT envoie un e-mail à chaque évènement important de l’onduleur. La valeur 2 permet d’avoir dans le mail l’état des l’onduleurs lors de l’évènement.

- UsersVars.NutSmtpRelay : Nom ou IP d’un relai SMTP pour y faire transiter le mail. Laisser vide ou saisissez none pour ne pas utiliser de relai (none par défaut).

- UserVars.NutMailTo : Adresse e-mail à laquelle envoyer les évènements de l’onduleur

- UserVars.NutMinSupplies : Pour les systèmes multi onduleurs. Le nombre d’onduleurs qui doivent être en capacité d’alimenter le système avant d’entamer un arrêt. Ce nombre doit être inférieur ou égal au nombre d’onduleurs définis dans UserVars.NutUpsName. Si vous ne respectez pas cette contrainte, le client ne démarrera pas. Avec un seul onduleur, laissez la valeur à 1.

Notez qu’à chaque modification de ces paramètres il sera nécessaire de faire un arrêt/relance du service pour leur prise en compte.

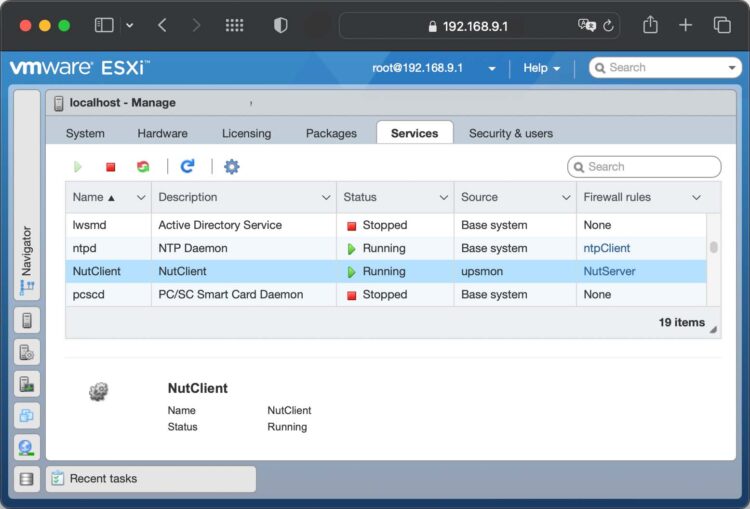

Lancement du service

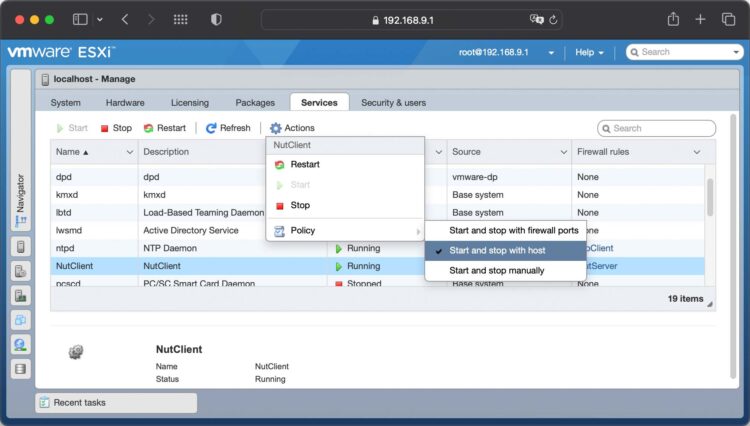

A l’aide de l’interface d’administration du ESXi, rendez-vous dans la rubrique gérer de l’hôte. Sélectionnez l’onglet Services, trouvez et sélectionnez le service NutClient dans la liste:

Dans les actions du service, choisissez la stratégie démarrage (Démarrer et arrêter avec l’hôte me semble un bon choix). Vous pouvez également le démarrer immédiatement ou l’arrêter.

Astuces

Utilisez la rubrique démarrage automatique de l’onglet Système de l’hôte ESXi pour décider de l’ordre de démarrage et d’arrêt (ou suspension) des machines virtuelles. Cet ordre sera respecté par la procédure d’arrêt sur alerte onduleur. Un bug de ESXi fait que les valeurs par défaut ne sont pas respectées. Vous devez configurer ces paramètre pour chaque VM au moins une fois (quitte à la dé-configurer ce qui la fera réellement suivre les règles par défaut).

Important : L’arrêt propre des OS dans les machines virtuelles n’est possible que si les vmware tools sont installées. Sinon l’arrêt sera brutal, préférez alors une suspension dans la configuration d’arrêt de la VM.

Là encore je rappelle que cette solution n’est pas adaptées aux fermes cluster avec haute disponibilité. Si HA est activé sur la machine hôte le mécanisme d’arrêt propre des VM n’est plus respecté et l’arrêt sera brutal pour toutes les VM.

UEFI secure boot

Si votre hôte ESXi est configuré pour booter en mode UEFI secure boot, l’installation du ViB restera compatible avec cette configuration. En revanche vous ne pouvez pas descendre le niveau d’acceptation à CommunitySupported quand secure boot est activé. Vous devrez :

- rebooter pour aller dans les paramètres UEFI de votre carte mère

- désactiver le secure boot dans les paramètres UEFI de votre carte-mère

- booter (sans secure boot)

- descendre le niveau d’acceptation à CommunitySupported

- Rebooter une seconde fois pour retourner dans les paramètres UEFI

- réactiver le secure boot

- booter (avec secure boot).

Vous aurez secure boot actif et le niveau d’acceptation minimal à CommunitySupported.

Désinstallation

Pour désinstaller le client NUT, utilisez le script upsmon-remove qui se trouve dans le fichier que vous avez téléchargé :

/tmp # sh upsmon-remove

Test

Pour estimer le temps nécessaire au serveur pour s’éteindre sur alerte onduleur tapez la commande « /opt/nut/sbin/upsmon -c fsd » sur le host ESXi (par ssh ou sur la console). La procédure d’arrêt est immédiatement lancée (ne faites pas ça si vous n’aviez pas prévu d’arrêter votre machine).

Cool que tu bosses encore dessus (pour tes propres besoins j’imagine) et que tu partages.

Merci encore 😉

Ce n’est même pas pour mes propres besoins, on m’avait demandé ces évolutions. J’avais du temps alors je l’ai fait.

ESX 5.5 est sur le point de sortir (certains ont mis la main dessus semble t-il….), des chanceux auraient pu tester pour voir si toujours compatible ? ( même si nous ne sommes qu’à moitié fous et que nous savons bien que la 5.5 ne sera utilisable en prod que dans un bon moment 🙂 )

Hi René!

Many thanks for you effort!

I am not a huge .nix expert, but out of curiosity I took ups-client tools from http://dl.fedoraproject.org/pub/epel/6/x86_64/nut-client-2.6.5-2.el6.x86_64.rpm and just unpacked to ESXi 5.1 datastore. upssched is working and other binaries (upsc, upsrw, etc.) are working too after creating links to libs existing in ESXi to satisfy binaries (eg libcrypto.so.10 to libcrypto.so.6, libssl.so.10 to libssl.so.0.9.8, to libupsclient in /lib64, etc.) After that I can connect to another NUT server, get ups status, data.

So may be you could try putting together a vib with all client tools?

Why do you want all binaries if you can’t use it as a NUT server ? USB ports are not usable from hypervisor. upssched needs a script and there is no easy way to add this in a configurable way in the ViB.

I won’t do that. Nut client ViB has to remain the smallest footprint in hypervisor

I would disagree that ports are unusable, NUT provides for drivers, though requiring extra libs and then likely nothing prevents from running as a NUT server. However this was not an intention.

Intention was to have clients of which upsmon+upssched needed to arrange early host shutdown say 300 sec after ONBATT and then start host by another server only when ONLINE and battery.runtime: 400 sec

All this is to overcome AMTs (Jetway nf9e-q77 with AMT 8) inability to start host after power loss when set to keep previous state rather than reboot – not sure that reboot at low UPS battery having the risk of another power loss is a good idea. Remaining batt capacity after host down, but without UPS down will alow hardware to stay « alive » for further boot or WoL.

As to a upssched’s script, probably a simple script can be configured with a template and vib then reassembled, but this is another future story. I feel comfortable enough to script, reassemble vib, etc., but not to recompile for esxi, so please …

I can send you a tar file with all binaries from nut project I have compiled for ESXi but I havent tested most of them.

I will really appreciate this! Can you see my email?

Yep, mail sent

Bonjour,

Je trouve super sympa le package.

Maintenant, les serveurs sont tous équipés de deux alimentations. Je n’ai pas trouvé le moyen de monitorer deux onduleurs correctement depuis ce package.

Avez-vous une idée ?

L’architecture multi onduleur n’est pas prévue mais pas impossible il y a des modifications à apporter dans le package.

Merci René de votre retour,

Vous avez une petite mise à jour ?

J’ai bien une idée pour faire ça sans tout remettre en cause : laisser la possibilité d’entrer une liste de serveurs NUT séparés par des virgules mais cela implique l’utilisation du même compte et mot de passe pour tous les serveurs NUT. Le nombre minimum d’onduleurs nécessaires resterait à 1. Le shutdown ne serait déclenché que si tous les serveurs NUT sont ONBATT puis LOWBAT.

Bonjour René,

J’ai essayé de mettre les deux onduleurs suivit pas une virgule ou point virgule. il ne se connecte pas serveur.

J’ai aussi essayé de mettre en dur les onduleurs dans fichiers templates, mais le fichier se ré-initialize au redémarrage.

Merci de votre aide

Normal, je ne l’ai pas encore implémenté. C’est pour une prochaine version mais actuellement je n’ai pas trop de temps libre.

Is ESXi 5.5 supported?

I don’t know, I haven’t upgraded yet. My ESXi server hangs at ACPI initialization on startup with ESXi 5.5

I managed to test this NUT client on ESXi 5.5 and it works all the same as ESXi 5.0 and 5.1

Cool de savoir qu’il passe sous 5.5 même si j’ai pas encore mis en prod ou en labo.

As tu des infos sur une version gérant plusieurs onduleurs?

J’ai pas encore eu le temps de regarder pour une version multi-onduleur. Ce n’est qu’une question de configuration, le client en est déjà capable.

René, merci pour ce superbe travail.

Il y a cependant un élément qui me manque que je vais devoir ajouter dans le package : le fait de pouvoir spécifier un serveur relais pour l’envoi des mails. En effet, l’utilisation du MX retourne le serveur de messagerie du domaine (externe dans mon cas et qui est inaccessible en cas de coupure électrique). J’ai besoin de pouvoir spécifier le serveur interne (à vocation technique).

L’objectif est de changer un peu le fichier « notify.sh » via une « variable ESX » supplémentaire.

à la place de

/bin/smtpblast -f « ${FROM} » -t « ${TO} »

écrire

if [ -z « ${RELAY} » ] ; then

/bin/smtpblast -f « ${FROM} » -t « ${TO} »

else

/bin/smtpblast -f « ${FROM} » -t « ${TO} » -r « ${RELAY} »

fi